Metoden A/B-testning kan användas som en del av datadriven design och innebär att man utvärderar två versioner av ett användargränssnitt parallellt för att ta reda på om den nya versionen presterar lika bra, bättre eller sämre än den gamla versionen. Förändringen av användargränssnitt kan vara av större eller mindre karaktär och handla om allt från en större re-design av en webbplats, omstrukturerade arbetsflöden till ändringar som syftar till att öka konverteringsgrad och lönsamhet. En annan anledning att utföra ett A/B test kan vara att man till har sett tecken på att vissa mindre grupper av användare verkar har vissa svårigheter att använda den nuvarande versionen av webbplatsen och man har implementerat en förändring som man hoppas ska lösa problemet utan att påverka upplevelsen negativt för andra grupper av användare.

Idealiskt ska en A/B testing utföras så att femtio procent av slumpvis utvalda användare får använda den nuvarande versionen A och 50 procent den uppdaterade version B. En annan viktig fråga som påverkar hur länge testet måste pågå för att resultatet ska vara statistiskt signifikant är hur många användare en sajt har och normalt antal konverteringar för det fall det är antal konverteringar som man vill jämföra mellan version A och B.

Ett exempel på detta är att man för sajten DeWalt [1] som säljer elverktyg ville testa ifall man kunde förbättra konverteringsgraden genom en så liten ändring som att byta text på en knapp från “Buy Now” till “Shop Now”. A/B tester visar dock att konverteringsgraden med denna ändring minskade med 17% ! Det här kan tyckas som ett fullständigt misslyckat försök men enligt artikeln lyckades man genom en serie av A/B/n tester till slut förbättra sajtens omsättning med ett sex-siffigt belopp.

I artikeln [2] från Adobe beskrivs andra varianter än 50/50 fördelning mellan A och B. Tex att successivt öka andelen som får se den variant som man under testet ser ger bäst konverteringsgrad – Det här är förstås en mer avancerad modell som kräver djupare kunskap om statistik för att utvärdera.

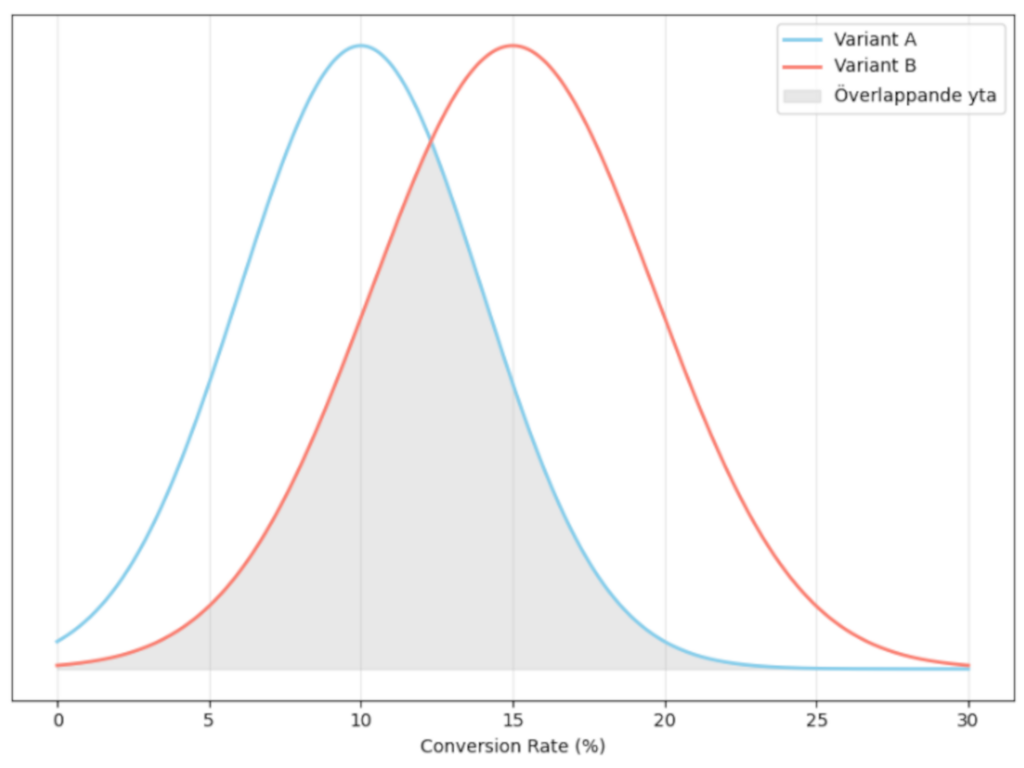

Artikeln beskriver också att man måste beräkna hur mycket bättre version B ska vara jämfört med A för att man med tillförlitlighet kan säga att den nya versionen är bättre genom ett exempel där man på något sätt har tagit reda på att det variant A har en “sann konverteringsgrad” på 10% och motsvarande för variant B är 15%. Om detta visas för 100 användare per variant så kan den observerade konverteringsgraden för variant A variera mellan 4% och 16% och för B variera mellan 8 och 22%. Men ju större populationen är desto säkrare kan man vara att beräknad konverteringsgrad är korrekt.

Artikeln i referensen ovan har tyvärr försvunnit sedan artikeln ovan skrevs men innehållet framgår på ett ungefär av den här artikeln : A/B Testing Sample Data Analysis for an E-commerce Website https://medium.com/@rachelinsujae/a-b-testing-sample-data-analysis-for-an-e-commerce-website-995f311a574b

[2] Adobe – How long should you run an A/B test?

https://experienceleague.adobe.com/en/docs/target/using/activities/abtest/sample-size-determination